How to จับผิด เมื่อมิจฉาชีพใช้ AI ลวง หน้า-เสียง เหมือน แต่อาจไม่ใช่ตัวจริง

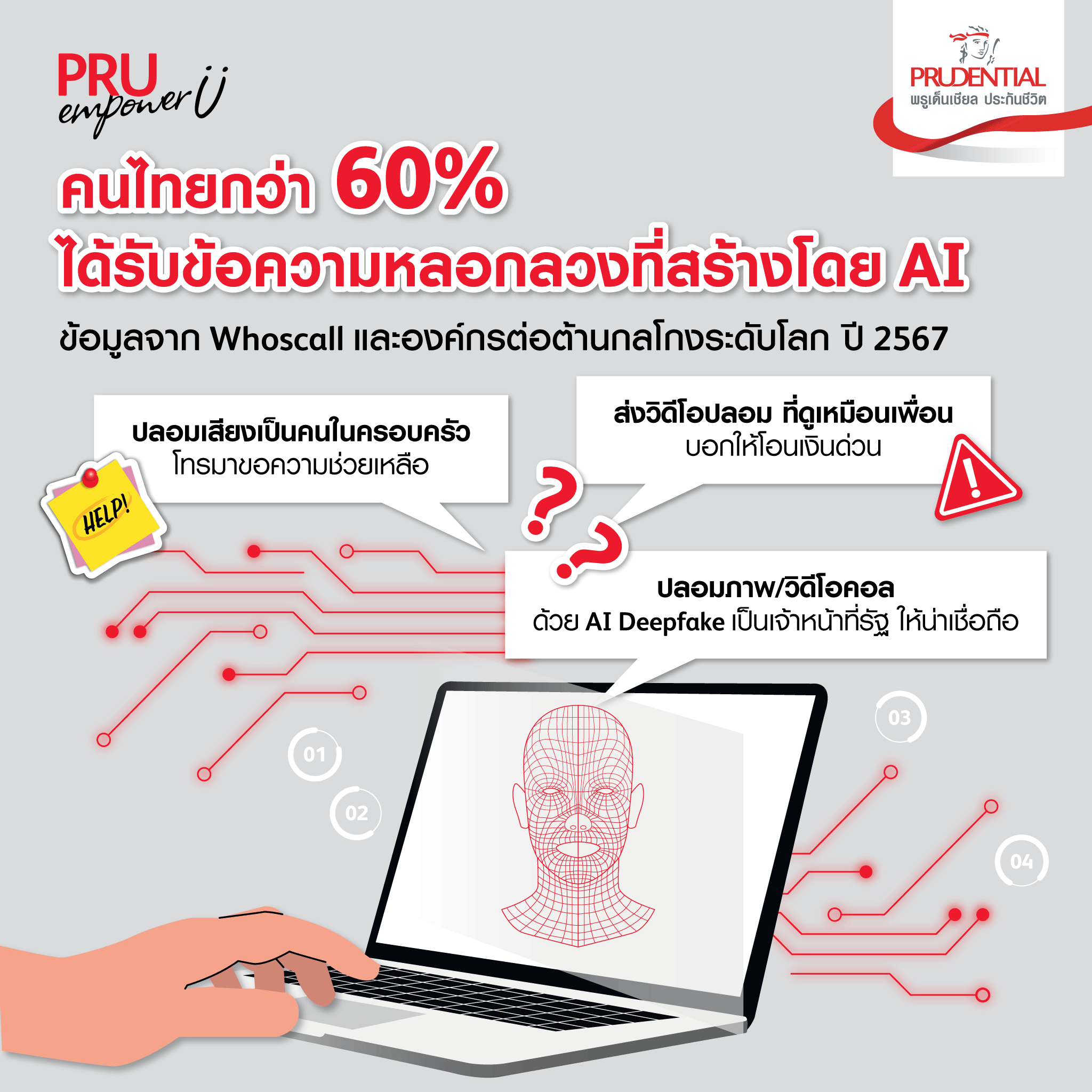

แม้จะมีการแจ้งเตือนและปราบปรามจากภาครัฐอย่างต่อเนื่อง เพื่อไม่ให้ประชาชนตกเป็นเหยื่อของพวกมิจฉาชีพ แต่ทุกวันนี้เรายังคงได้รับสายจาก “แก๊งคอลเซ็นเตอร์” ที่โทรมาหลอกลวง และยังมีรูปแบบ เทคนิคกลโกงใหม่ ๆ เพื่อสร้างความน่าเชื่อถือ ทำให้หลายคนหลงเชื่อ ตกเป็นเหยื่อ และสูญเงินเป็นจำนวนไม่น้อย ข้อมูลจาก State of scam in Thailand 2024 โดย Whoscall และองค์กรต่อต้านกลโกงระดับโลก ปี 2567 พบว่า กว่า 60% ของคนไทย ได้รับข้อความหลอกลวง ที่สร้างโดย AI ไม่ว่าจะจากช่องทาง SMS หรือโซเชียลมีเดีย

กลโกงใหม่! สร้างโดย AI รู้ไว้ไม่เสียที

-

การปลอมเสียง (Voice Cloning)

Voice Cloning คือ การใช้ AI เพื่อเลียนแบบเสียงของบุคคลหนึ่ง ๆ ให้เหมือนจริง โดยใช้ตัวอย่างเสียงเพียงไม่กี่วินาที AI สามารถสร้างเสียงพูดของบุคคลนั้นขึ้นใหม่ ซึ่งมิจฉาชีพใช้เทคนิคนี้ในการแอบอ้างเป็นคนในครอบครัว ญาติ เพื่อน คนรู้จัก คนในที่ทำงาน หรือบุคคลที่มีชื่อเสียงน่าเชื่อถือ เพื่อให้เหยื่อหลงเชื่อและคล้อยตาม โดยจะหลอกขอความช่วยเหลือ เช่น โอนเงิน หรือให้ข้อมูลสำคัญต่าง ๆ เป็นต้น

-

การปลอมภาพและวิดีโอ (AI Deepfake)

AI Deepfake คือ เทคโนโลยีที่ใช้ AI สร้างภาพหรือวิดีโอปลอมที่ดูเหมือนจริงอย่างมาก โดยสามารถสร้างสื่อสังเคราะห์ ทั้งภาพนิ่ง เสียง ภาพเคลื่อนไหวพร้อมเสียง ที่เหมือนเป็นคนมาพูดคุยจริง ๆ จนแทบแยกไม่ออก ด้วยระบบการเรียนรู้ (Deep Learning) จากลักษณะภายนอกของบุคคล หรือใช้โปรแกรม Face Swap สลับสับเปลี่ยนหน้าตา จึงทำให้การสร้างภาพและเสียงมีความเหมือนราวกับว่า คน ๆ นั้นเป็นคนพูดจริง ๆ มิจฉาชีพจึงใช้เทคนิคนี้ในการสร้างภาพหรือวิดีโอเพื่อหลอกลวง เช่น ปลอมเป็นผู้มีชื่อเสียง หรือเจ้าหน้าที่ของรัฐ เพื่อทำให้ตกใจกลัว และหลอกให้โอนเงินไปเพื่อตรวจสอบ หลอกยืมเงิน หรือทำวิดีโอปลอมเพื่อแบล็กเมลเหยื่อ เป็นต้น

สังเกตและเอะใจ จะได้ไม่โดนมิจฉาชีพใช้ AI มาหลอก

จับจุดสังเกตเหล่านี้ให้ดี! เมื่อเราไม่แน่ใจว่าปลายสายหรือคลิปที่เห็นนี้เป็นคนจริง หรือ AI ลองดูข้อสังเกตเหล่านี้ที่มิจฉาชีพมักจะใช้บ่อย ๆ เช่น

-

โทรมาไม่พูด ปล่อยให้เราพูดคนเดียว แล้ววางสายไป อาจเป็นสัญญาณไม่ดี ที่เราอาจจะโดนอัดเสียง เพื่อนำเสียงไปให้ AI ลอกเลียนแบบ แล้วนำไปหลอกคนใกล้ชิด หรือครอบครัว

-

ปลายสาย เสียงเหมือนคนรู้จัก แต่ใช้เบอร์แปลกโทรมา หรืออ้างว่าเปลี่ยนเบอร์ใหม่ ให้สงสัยไว้ก่อนเลยว่ามิจฉาชีพแน่นอน

-

พูดเรื่องประเด็นเงิน ๆ ทอง ๆ มาก่อนเรื่องอื่น หรือสร้างสถานการณ์ที่ต้องการเงินด่วน ปิดท้ายด้วยการขอยืมเงิน

-

มักพูดประโยคสุดคลาสสิก “จำเราได้ไหม?” เพื่อให้เหยื่อเดา และพูดชื่อคนรู้จักออกมา แล้วมิจฉาชีพก็จะสวมรอยเป็นคนรู้จักทันที หากเหยื่อคล้อยตามก็จะชวนคุย และโน้มน้าวให้โอนเงิน

-

เมื่อมีเจ้าหน้าที่ตำรวจใส่เครื่องแบบเต็มยศ โทรหรือวีดีโอคอลมาแจ้งข้อกล่าวหา สอบปากคำทางไลน์ และให้โอนเงินมาตรวจสอบว่าผิดกฎหมาย หรือให้โอนเงินทุกกรณี สงสัยไว้เลยว่าเป็นมิจฉาชีพ

-

เสียงจาก AI มักจะเว้นวรรคคำพูดผิดเพี้ยน ไม่มีจังหวะหายใจ ใช้คำพูดแปลก ๆ น้ำเสียงราบเรียบ ไม่มีการเน้นน้ำหนักเสียง ใช้คำพูดฟุ่มเฟือย พูดคำศัพท์เฉพาะไม่ค่อยชัด บางคำออกเสียงผิดเพี้ยน เป็นต้น

-

ใบหน้าจาก AI มักดูไม่เป็นธรรมชาติ ใบหน้าผิดสัดส่วนเมื่อหันซ้าย-ขวา ขยับปากไม่ตรงจังหวะ สีผิวไม่สม่ำเสมอ มักอ่อนหรือเข้มเป็นหย่อม ๆ แสงเงาบริเวณผิวไม่สอดคล้องกับการเคลื่อนไหว และกระพริบตาถี่หรือน้อยเกินไป

ป้องกันอย่างไร ไม่ให้ตกเป็นเหยื่อ

-

อย่าเชื่อในทันที เมื่อได้รับสายจากคนที่อ้างว่าเป็นญาติหรือเพื่อน ควรกดวางสายแล้วตรวจสอบข้อมูลให้แน่ชัด

-

ควรมีรหัสลับ หรือข้อมูลที่รู้กันเฉพาะบุคคล เป็นคำถามเชิงลึกเพื่อยืนยันตัวตน เช่น วันเกิดของพ่อแม่ ชื่อสัตว์เลี้ยง ชื่อเล่นของพี่น้อง ชื่อโรงเรียนเดิม ชื่อสถานที่ทำงาน หรือตัดบทขอติดต่อกลับเอง เพื่อเปิดช่องให้ได้ตรวจสอบกับแหล่งข้อมูลหรือช่องทางอื่น ๆ ก่อน

-

ไม่รับสายเบอร์แปลก แต่ถ้าจำเป็นต้องรับสาย ควรปล่อยให้อีกฝ่ายพูดก่อน เพื่อป้องกันการถูกอัดเสียง หากได้ยินเสียงแล้วไม่ลื่นไหลเหมือนเสียงมนุษย์ ก็อาจจะตีความได้ว่ากำลังคุยกับ AI อยู่ ให้รีบกดวางสาย

-

หลีกเลี่ยงการแชร์ข้อมูลส่วนตัว ภาพ หรือวิดีโอ ซึ่งอาจถูกนำไปใช้โดยมิชอบ เช่น นำไปตัดต่อ ดัดแปลง ทำให้เกิดความเสียหาย และหลอกลวงผู้อื่น

-

ไม่ส่งข้อมูลทางการเงิน ผ่านทางโทรศัพท์หรือออนไลน์ หากไม่แน่ใจในความปลอดภัย

-

ตั้งสติ และตรวจสอบความถูกต้อง หากได้รับการติดต่อจากหน่วยงานของรัฐ หรือติดต่อเรื่องคดีความ เรื่องผิดกฎหมายต่าง ๆ ตั้งสติให้ดี อย่าตกใจ แล้วแจ้งว่าขอติดต่อกลับเอง รีบวางสาย ปรึกษากับครอบครัว และติดต่อกลับไปยังหน่วยงานหรือบุคคลที่เกี่ยวข้องผ่านช่องทางทางการที่เชื่อถือได้

-

ติดตามข่าวสาร และเรียนรู้เกี่ยวกับกลโกงรูปแบบใหม่ เพื่อเพิ่มความระมัดระวังในการป้องกันตนเอง

-

ตรวจสอบวิดีโอ deepfake เบื้องต้นได้ในเว็บไซต์ > https://scanner.deepware.ai/

-

ลองฝึกแยกภาพจริงกับภาพที่สร้างด้วย AI ได้บนเว็บไซต์ > https://detectfakes.media.mit.edu/

-

เช็กเว็บไซต์ปลอม เบอร์ต้องสงสัย บัญชีธนาคาร แจ้งเบาะแสออนไลน์ ได้ที่เว็บไซต์กองบัญชาการตำรวจสืบสวนสอบสวนอาชญากรรมทางเทคโนโลยี > https://www.checkgon.com/

เมื่อตกเป็นเหยื่อมิจฉาชีพต้องทำอย่างไร?

หากตกเป็นเหยื่อแก๊งคอลเซ็นเตอร์ สามารถแจ้งความได้ตลอด 24 ชั่วโมง โดยแจ้งความออนไลน์ได้ที่ กองบัญชาการตำรวจสืบสวนสอบสวนอาชญากรรมทางเทคโนโลยี (บช.สอท.) ที่เว็บไซต์ https://thaipoliceonline.go.th/ หรือ โทร. 1441 เพื่อให้เจ้าหน้าที่ตำรวจประสานงานไปยังธนาคารที่เกี่ยวข้องในการร่วมกันยับยั้งความเสียหายที่เกิดขึ้น และติดตามผู้ก่อเหตุได้รวดเร็วยิ่งขึ้น ทั้งนี้ หลังจากแจ้งความ และดำเนินการอายัดบัญชีเสร็จสิ้น สามารถติดตามการอัปเดตสถานะคดี และการดำเนินการ ทั้งจากธนาคารและตำรวจได้

อ้างอิง

ระวัง! ตร.แนะวิธีสังเกตมิจฉาชีพใช้ "AI" ปลอมเป็น "คน" แอบอ้างหลอกลวงเหยื่อ

มุกใหม่มิจฉาชีพ โทรไม่พูด อัดเสียงเรา เทรน AI ปลอมเสียงหลอกคนอื่น

วิธีจับผิด AI ไม่ให้โดนหลอก! อันไหนของจริง อันไหน AI ดูยังไง? รู้ทันมิจฉาชีพยุคเอไอ